2025.02.20

センサー体験展示「HACK THE WORLD」

AaaS Tech Labは、博報堂・博報堂DYメディアパートナーズが主催するインターンシップ「データサイエンス篇 <エンジニアリングコース>」にて、企画・運営・選考を担当しています。

コロナ禍以降オンライン開催が続いていましたが、今年度からは学生に会社や社員のことをより知ってもらう為、また我々も学生の個性や強みをより深く理解する為、オフラインの場で学生と交流する日程を設けました。

その取り組みの一環として、2024年度冬期開催時には「HACK THE WORLD」と称し、センサーデバイスを活用した体験型の展示を行いました。

コロナ禍以降オンライン開催が続いていましたが、今年度からは学生に会社や社員のことをより知ってもらう為、また我々も学生の個性や強みをより深く理解する為、オフラインの場で学生と交流する日程を設けました。

その取り組みの一環として、2024年度冬期開催時には「HACK THE WORLD」と称し、センサーデバイスを活用した体験型の展示を行いました。

概要

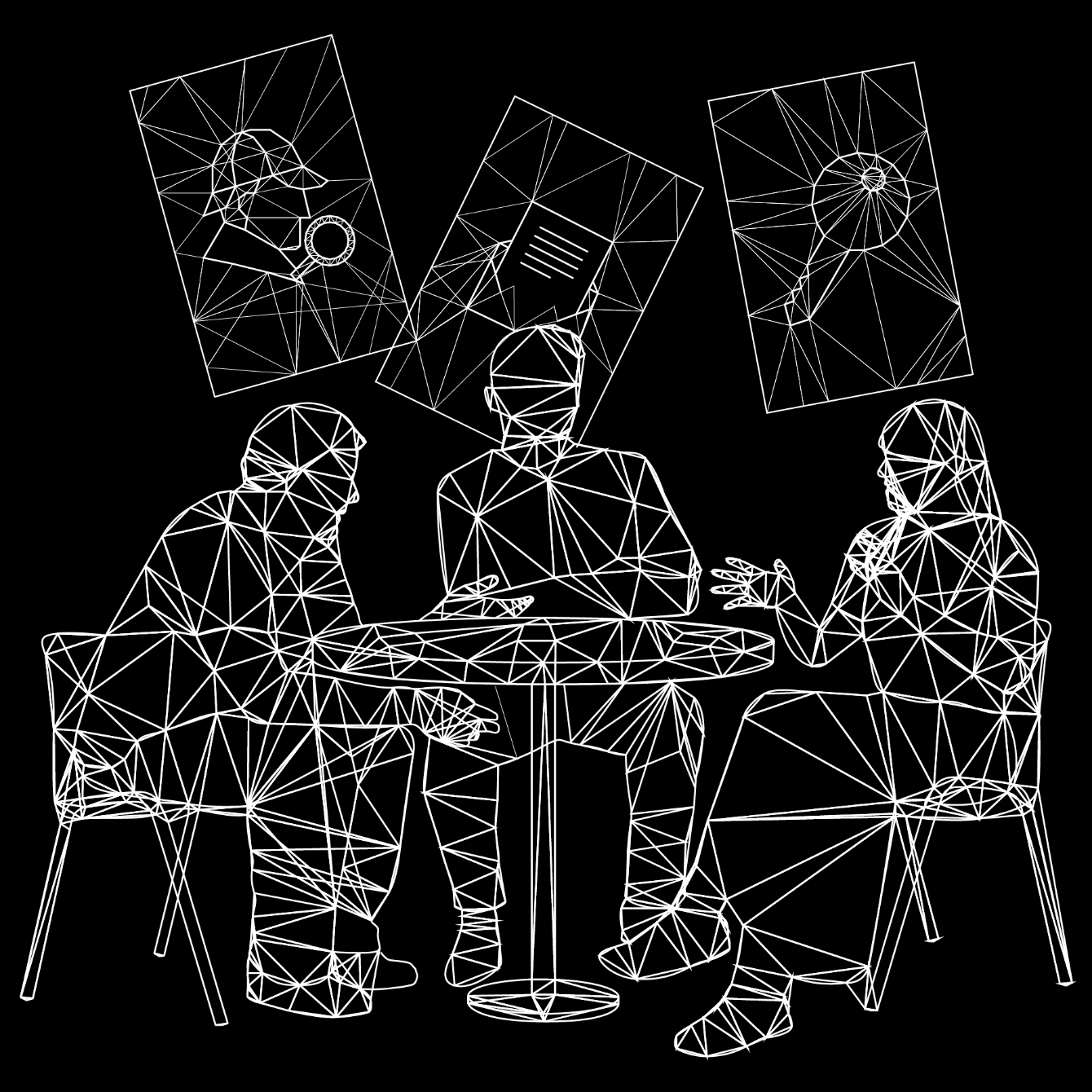

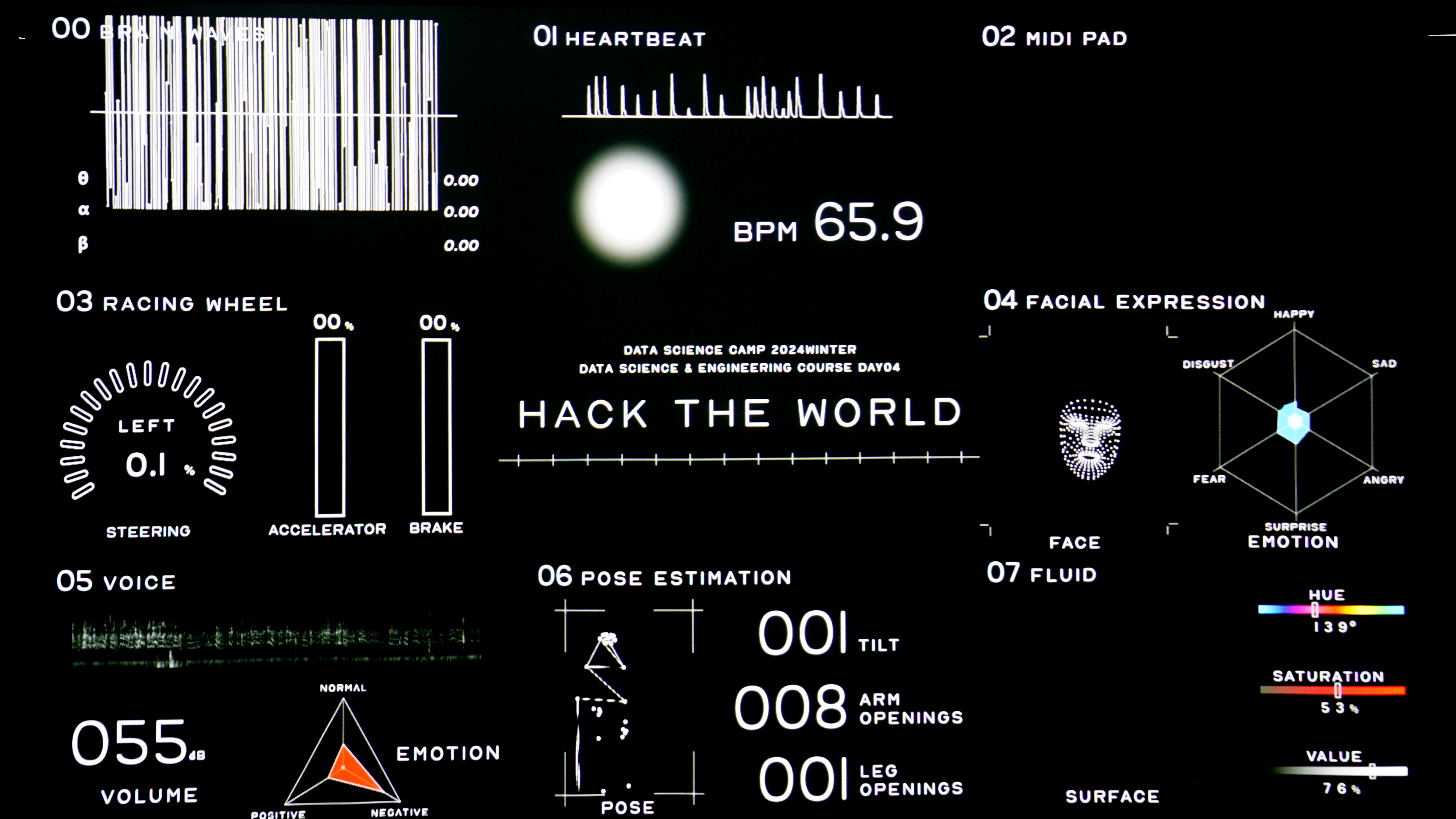

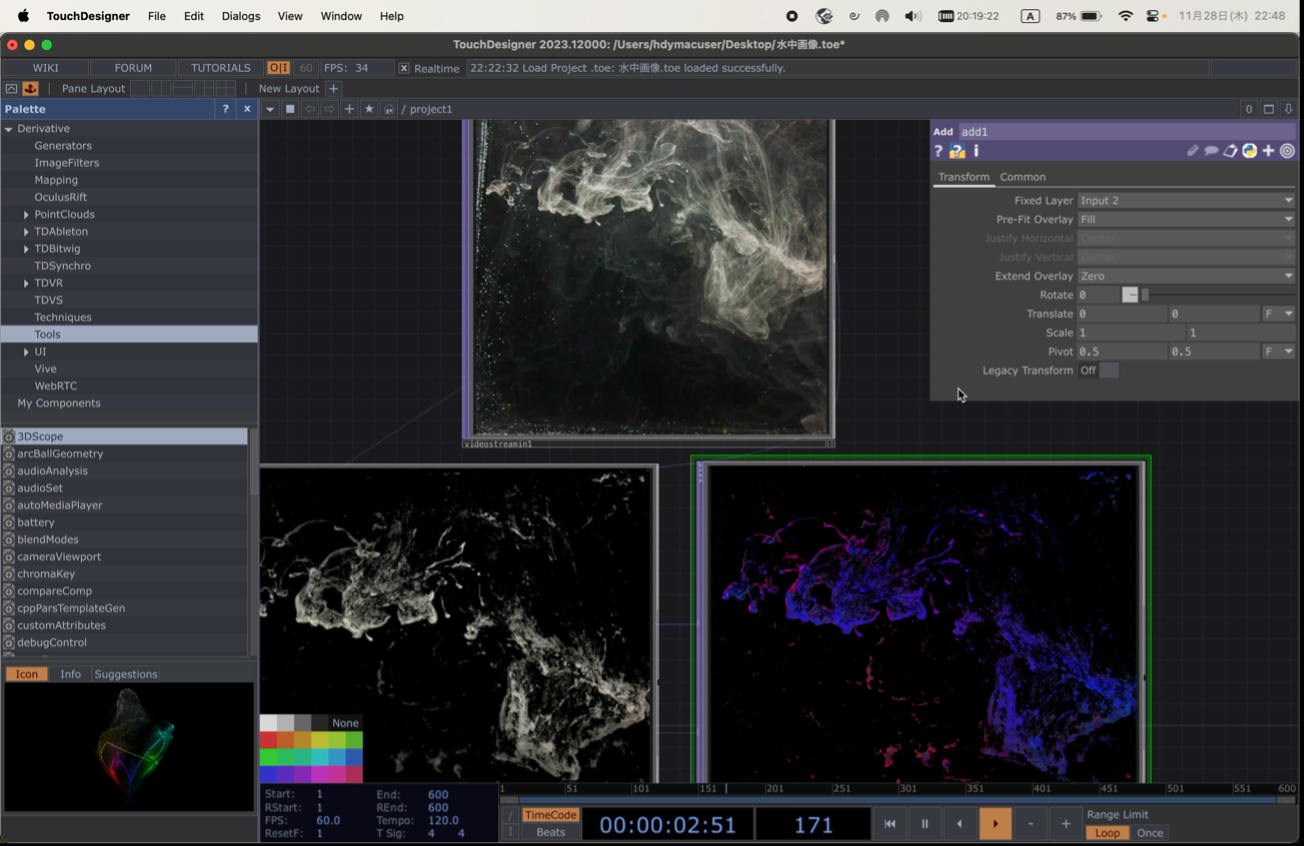

「HACK THE WORLD」は、8つの生体・行動センサーデバイス (脳波/心拍/MIDI/ステアリングコントローラー/表情/音声/姿勢/流体) と、2つの深度カメラ (後半のみ)から構成され、それらから取得されるデータを1台のPC上に集約し、TouchDesigner[1]でリアルタイム処理、ビジュアライズや体験演出に活用しました。

展示進行は前後半に分け、

・前半 : UIを通してデータ/デバイスを理解する体験

・後半 : 深度カメラで取得した点群を、自らの生体・行動データで変化させる体験

という流れにしました。

・前半 : UIを通してデータ/デバイスを理解する体験

・後半 : 深度カメラで取得した点群を、自らの生体・行動データで変化させる体験

という流れにしました。

前半 : UI画面でのデータビジュアライズ

このパートでは、リアルタイムに各種センサーから得られたデータを本パート用に実装したUI画面にビジュアライズしました。各種センサーデバイスに触れたことのない学生もいると考え、まずはシンプルに、どのような入力(状態/行動)に対して、どのような値が出力されるのか、直感的に理解できる時間を設けました。

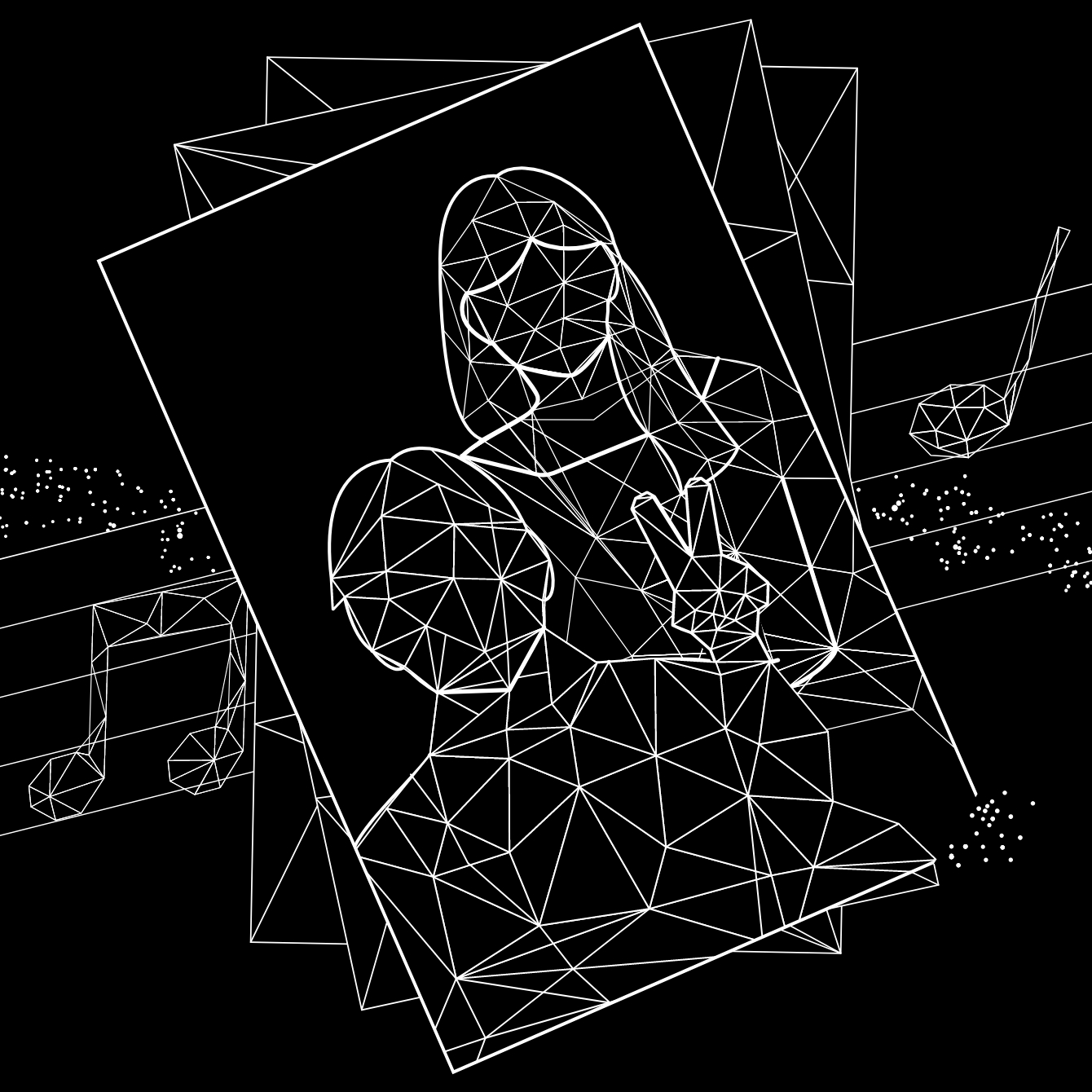

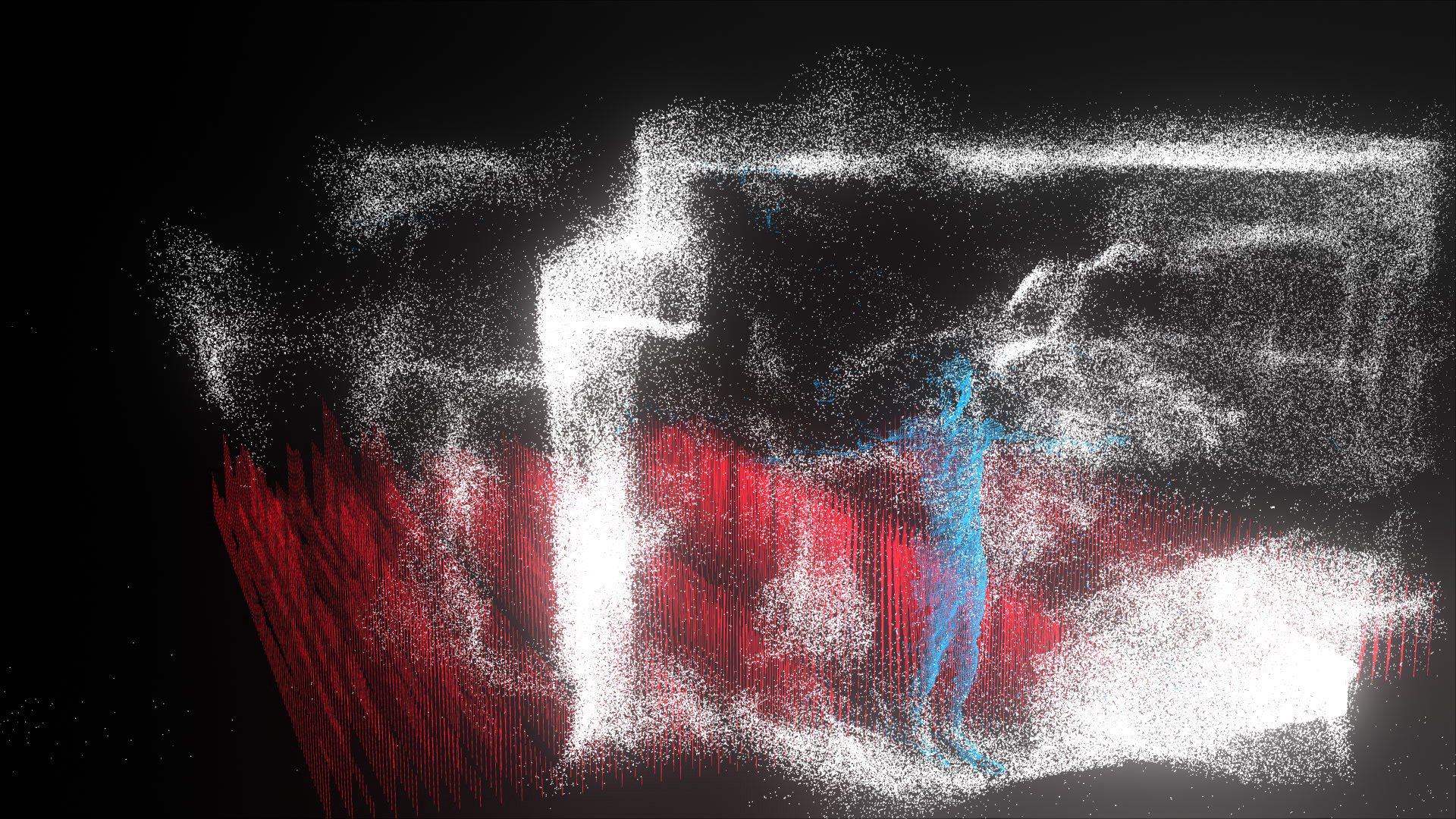

後半 : 深度カメラの点群映像を自らの生体/行動データで変化させる体験

後半は深度カメラを活用し、展示空間や人の点群データをリアルタイム取得した上で、学生(体験者)の生体/行動データにより、その点群をインタラクティブに変化させる体験を提供しました。自分自身の行動が周りの環境に影響を与えるということを表現しています。

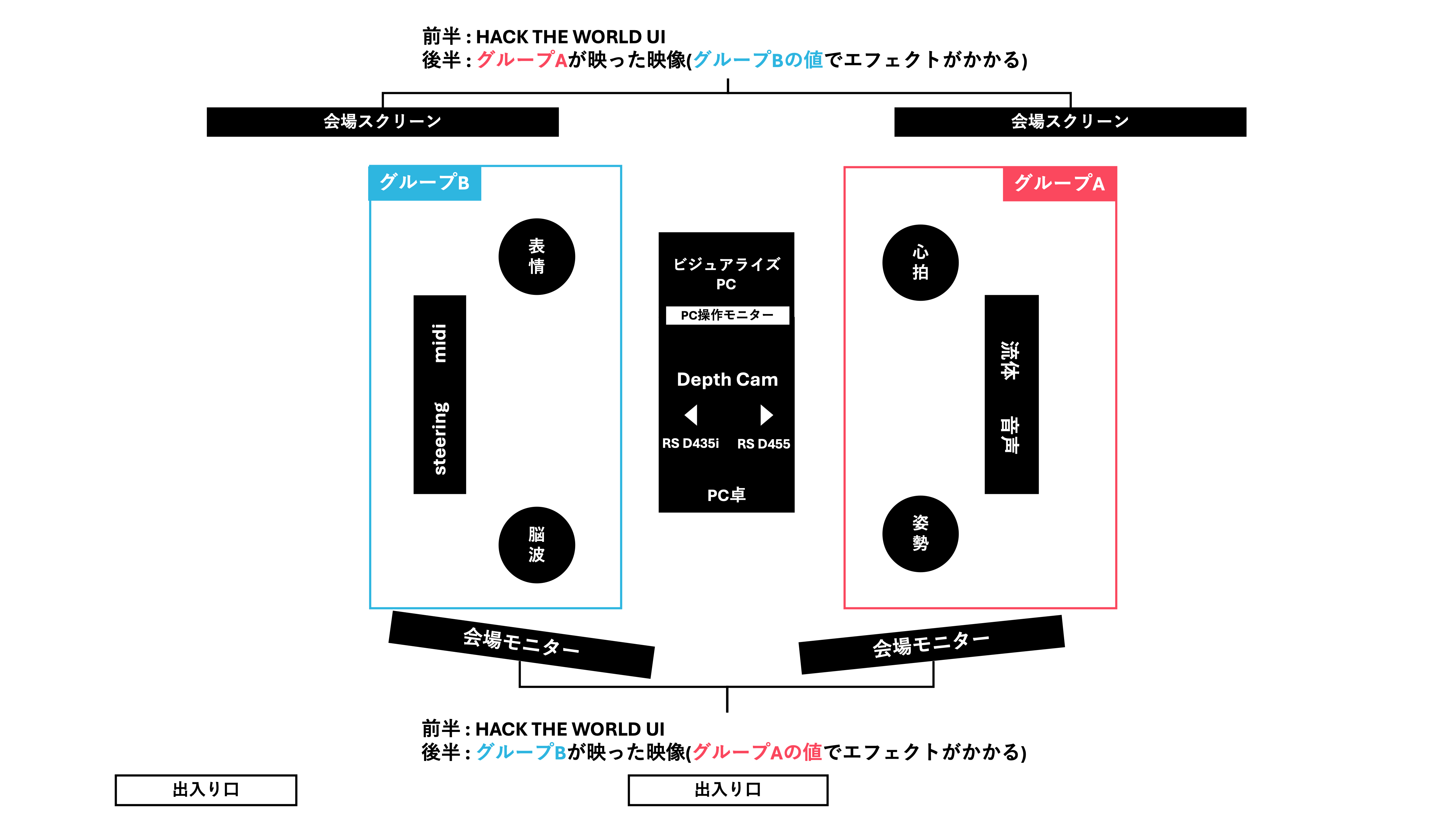

8種類の生体/行動センサー・深度カメラ・モニターの配置は下図のようにしました。展示意図実現のために、8種類のセンサーは4種類ずつに向かい合わせに配置、さらに2つの深度カメラは真逆方向に配置しました。自分の生体/行動データが、向かいにいる人や空間を変化させるように作用する構成にしています。

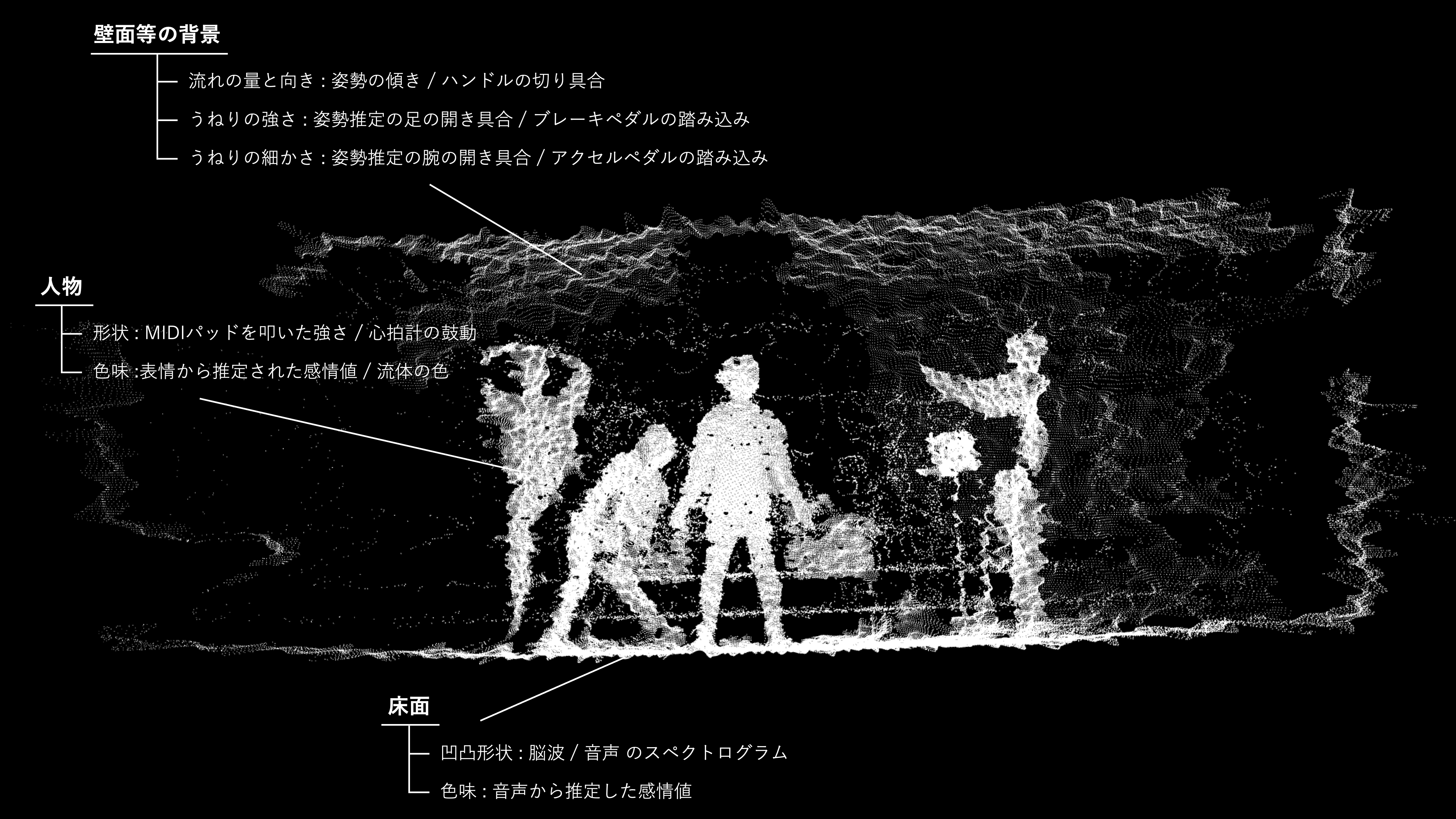

ただ、単純に上記構成で進めると、1つの深度カメラ映像全体に対して、4つのセンサーデータがすべて同時に作用し出力映像が無秩序になりすぎる懸念がありました。そこで、深度カメラの映像情報を、YOLO[2]に入力し、リアルタイムにインスタンスセグメンテーション[3]を実施し、映像上でセグメントした人物や背景の情報を、点群データと組み合わせることで、「人物だけの点群」や「背景だけの点群」を作成しました。これにより下図のようなイメージで、特定の生体・行動データを、特定の点群パートにのみ作用させ、映像が混沌としない処理を目指しました。

8つの生体・行動データ

脳波

デバイス:Muse2

ソフトウェア:Mind Monitor

脳波の取得には、リアルタイムにセンシングでき、装着が容易なMuse2を用いました。センシングした脳波をMind Monitor経由でOSC通信によってTouchDesignerに送信しました。alpha、beta、gamma、theta波の変化によって推計される”集中度”や”リラックス度”のような指標の変化を感じてもらいました。

ソフトウェア:Mind Monitor

脳波の取得には、リアルタイムにセンシングでき、装着が容易なMuse2を用いました。センシングした脳波をMind Monitor経由でOSC通信によってTouchDesignerに送信しました。alpha、beta、gamma、theta波の変化によって推計される”集中度”や”リラックス度”のような指標の変化を感じてもらいました。

心拍

デバイス:Arduino, ear clip型心拍センサ

ソフトウェア:Arduino IDE

心拍センサは、耳たぶにクリップを挟み、血管の収縮をセンシングすることでその収縮周期から心拍数を推定するものを用いました。血管の膨張/収縮のタイミングをセンシングし、送信されたパルスをTouchDesigner上で受け取りUIへ描写、あるいは点群をパルスに合わせて収縮させるエフェクトを付与しました。

ソフトウェア:Arduino IDE

心拍センサは、耳たぶにクリップを挟み、血管の収縮をセンシングすることでその収縮周期から心拍数を推定するものを用いました。血管の膨張/収縮のタイミングをセンシングし、送信されたパルスをTouchDesigner上で受け取りUIへ描写、あるいは点群をパルスに合わせて収縮させるエフェクトを付与しました。

MIDI

デバイス : AKAI / MPK mini MK3

ソフトウェア : AKAI MPC Beats

MIDIパッドを叩いた時に、どのような音が流れるかをMPC Beatsで制御し、「どのパッドをどれくらいの強さで叩いたか」「ノブ・コントロールの数値」をOSC通信により、映像を制御しているPCに送信しました。

ソフトウェア : AKAI MPC Beats

MIDIパッドを叩いた時に、どのような音が流れるかをMPC Beatsで制御し、「どのパッドをどれくらいの強さで叩いたか」「ノブ・コントロールの数値」をOSC通信により、映像を制御しているPCに送信しました。

ステアリングコントローラー

デバイス:ロジクール ステアリングコントローラーG29

ステアリング・アクセル・ブレーキがセットになったステアリングコントローラーをPCに有線接続し、TouchDesigner上で入力信号を受信しました。本格的なドライブシミュレータで使用されるコントローラーであるため、アクセル・ブレーキの踏み込み具合を0か1ではない連続値で取得ができました。

ステアリング・アクセル・ブレーキがセットになったステアリングコントローラーをPCに有線接続し、TouchDesigner上で入力信号を受信しました。本格的なドライブシミュレータで使用されるコントローラーであるため、アクセル・ブレーキの踏み込み具合を0か1ではない連続値で取得ができました。

表情

デバイス:Macbookウェブカメラ

表情はMedia Pipe Face Landmarker[4]を使用し、PCカメラからの顔画像のランドマーク検出を行いTouchDesigner上でビジュアライズしました。上記と並列でface-apiを用いた表情からの感情推定処理を実行し、OSC通信で感情推定結果をTouchDesignerに送信しました。

表情はMedia Pipe Face Landmarker[4]を使用し、PCカメラからの顔画像のランドマーク検出を行いTouchDesigner上でビジュアライズしました。上記と並列でface-apiを用いた表情からの感情推定処理を実行し、OSC通信で感情推定結果をTouchDesignerに送信しました。

音声

デバイス : コンデンサーマイク = Audio-Technica AT4040, オーディオインターフェース = SSL2

音声は、マイクから入力したのち、TouchDesignerを用いて、喜び・悲しみ・緊張の3種類の感情出力ができるようにしました。まずマイクで取得した音声データをOSC通信により、映像を制御しているPCに送信し、Spectrogramに変換しました。次に音の振幅を計算し、それをデシベルスケールに変換しました。最後にRMS(音量)、ゼロ交差率(ZCR)、スペクトルフラットネスを計算し、喜び、悲しみ、緊張の3種類の感情スコアを計算しました。音を入力とし、声色やピッチを変えることで様々な表現ができる仕掛けを試みました。

音声は、マイクから入力したのち、TouchDesignerを用いて、喜び・悲しみ・緊張の3種類の感情出力ができるようにしました。まずマイクで取得した音声データをOSC通信により、映像を制御しているPCに送信し、Spectrogramに変換しました。次に音の振幅を計算し、それをデシベルスケールに変換しました。最後にRMS(音量)、ゼロ交差率(ZCR)、スペクトルフラットネスを計算し、喜び、悲しみ、緊張の3種類の感情スコアを計算しました。音を入力とし、声色やピッチを変えることで様々な表現ができる仕掛けを試みました。

姿勢

デバイス:Macbookウェブカメラ

MediaPipe Pose Landmarker[5]を使用し、カメラに写っている人体の右肩、左肩、右腰、…といった計33個の主要ポイントを検出しビジュアライズしました。加えて、検出されたポイント座標をもとに腕の開き・脚の開き・体の傾きを計算しUI上に表示しました。これらの3指標は体験者にとってコントローラブルな値であり、様々な姿勢を試しながら値の制御を楽しんでもらえるようにしました。

MediaPipe Pose Landmarker[5]を使用し、カメラに写っている人体の右肩、左肩、右腰、…といった計33個の主要ポイントを検出しビジュアライズしました。加えて、検出されたポイント座標をもとに腕の開き・脚の開き・体の傾きを計算しUI上に表示しました。これらの3指標は体験者にとってコントローラブルな値であり、様々な姿勢を試しながら値の制御を楽しんでもらえるようにしました。

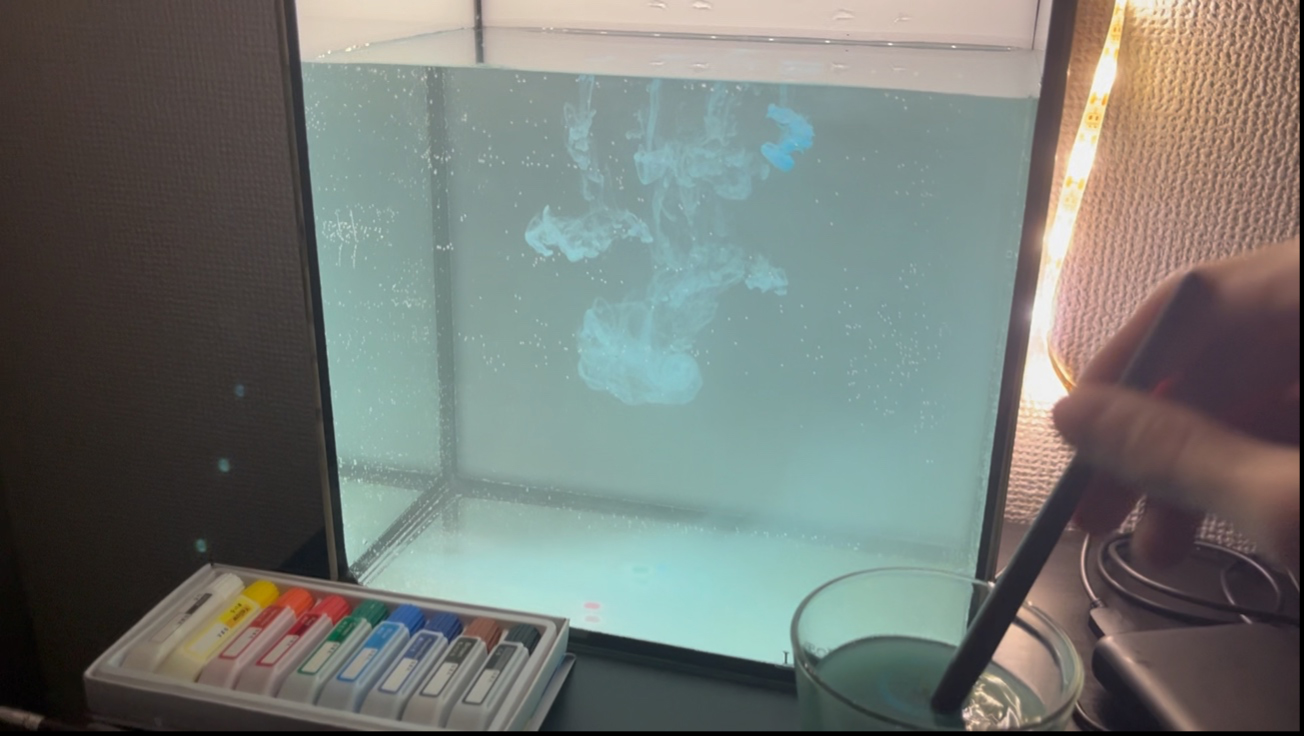

流体

デバイス:RaspberryPi4, RasperryPi用カメラモジュール

ソフトウェア:MediaMTX

RaspberryPiにカメラを接続し水槽を横から撮影することで、体験者が水面に落とした絵の具の水中での広がりを計測しました。

ソフトウェア:MediaMTX

RaspberryPiにカメラを接続し水槽を横から撮影することで、体験者が水面に落とした絵の具の水中での広がりを計測しました。

RaspberryPiで撮影された映像をPCへ送信し、TouchDesigner で前景と背景の分離をリアルタイムで実行し、その結果をそのままUI上へ描写しました。また、落とした絵の具のHSV色空間での値をTouchDesigner上で取得し、点群の色を変えるエフェクトに活用しました。

水槽の表面はガラスであるため、例えば、「体験者の後ろを通る人などが映り込む」、「照明やプロジェクターの光に影響されて前景と背景の分離がうまくいかない」といった問題が発生します。これらに対処するために、PC用の反射防止フィルムを、カメラが撮影する面に貼ることで、外部の光の反射を抑えました。また、カメラが撮影する面以外の面を真っ白にすることでも、映り込みを低減することができました。

最後に

AaaS Tech Labのミッションは「従来の広告ビジネスやメディア・コンテンツを革新するためにテクノロジーの可能性を探求する」ことです。そのため我々の業務は、高度なアルゴリズムを用いてTV番組の視聴率や、デジタル広告のクリック率を予測することはもちろん、テクノロジーを活用した新しいコンテンツ体験を創出することも含まれます。例えば、過去にtechnolotea[6]やw3[7]など、脳波/表情などのデータを体験/空間演出に活用した事例もあります。

一言で「データサイエンス・データサイエンティスト」といっても、関わることのできる領域は想像以上に多様なのではないか。まだ気づいていない、データを用いることの面白さ・楽しみ方があるのではないか。そのような想いを学生と共有することを目指し、インターンの内容を設計しました。

-

view more --->小山田 圭佑Keisuke Oyamada

============== -

view more --->樋口 建Takeru Higuchi

==============.worksはままつオトミヤゲ -

view more --->平川 智也Tomoya Hirakawa

==============.works体験!さわれる!?不思議な未来の天気 -

view more --->細井 晃貴Koki Hosoi

==============.worksしず旅スタンプラリー -

view more --->篠田 裕之Hiroyuki Shinoda

==============

<‑‑

‑‑>

タグ一覧

#次世代メディアデータ基盤#メディアソリューション#TV視聴ログ#GPS位置情報データ#メディア・コンテンツ開発#レシピデータ#自然言語処理#音声処理#表情感情推定#脳波#画像生成#text2image#Diffusion Model#3Dモデリング#PIFu#Mixamo#音声合成#Zero-Shot learning#Multilingual TTS#最適化#イベント登壇#人工知能学会#Developers Summit#デブサミ#エモテク#TV番組分析#SNSデータ#声質変換#Voice Conversion#Retrieval-based Voice Changer#image to 3d#NeRF#Volume Rendering#3D Reconstruction#空中触覚デバイス#フォトグラメトリ#初音ミク#AIラッパー#雑誌データ分析#リアルタイム生成#プロフィール推定#音楽生成#LLM#台本データ#3D Gaussian Splatting#CVPR#歌詞生成#センサーデータ#データサイエンスインターン